Semaine 7

Activité 3

Méthodes d’évaluation par les participants

Sommaire

- Présentation des types d’approche : en laboratoire et sur le terrain

- Présentation des méthodes d’évaluation par verbalisation (Think Aloud), d’évaluation coopérative et d’évaluation a priori/a posteriori

- Étude de cas

Présentation des types d’approche : en laboratoire et sur le terrain.

L’évaluation des participants peut se faire en laboratoire ou directement sur le terrain (autrement dit, dans un contexte d’utilisation). La méthode d’évaluation est dite empirique, car elle permet d’évaluer des utilisateurs réels exécutant des tâches réelles. L’objectif est de recueillir des données comportementales sur l’utilisation du système et d’évaluer le système/le produit en fonction d’observations faites par des utilisateurs.

L’étude se déroule de la même manière, qu’elle ait lieu en laboratoire ou sur le terrain. Avant de faire passer les tests, il faut d’abord identifier des fonctionnalités significatives (scénarios types) et déterminer quels sont les éléments du système à évaluer, puis recruter un panel d’utilisateurs cibles. Des observations sont relevées pendant le test par le concepteur. Pour recueillir les opinions des utilisateurs, on peut utiliser des questionnaires (sous la forme de questions à choix multiple, de questions dichotomiques ou d’échelles) et/ou des entretiens (avec questions dirigées, semi-dirigées ou ouvertes sans suggestion) qui permettent également de faire ressortir les connaissances et les opinions des utilisateurs. Ensuite, l’examinateur analyse les verbalisations et les observations obtenues. Enfin, l’examinateur peut présenter un rapport faisant état des problèmes et des solutions envisagées pour améliorer le système évalué.

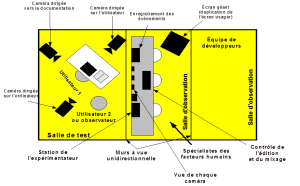

En laboratoire, les utilisateurs sont observés pendant qu’ils passent les tests d’acceptabilité, ce qui permet de recueillir un grand nombre de données (p. ex., impressions des utilisateurs avant et après l’utilisation, réussites et incidents lors de l’utilisation). Bien souvent, les tests sont enregistrés sous format vidéo ou audio, ce qui permet d’obtenir des verbalisations « spontanées » de l’utilisateur pendant qu’il utilise le système. Il existe également des mouchards électroniques qui recueillent les données telles les stratégies utilisées, les séquences d’action, les performances obtenues, etc.

Sur le terrain, le recueil de données peut différer du recueil de données en laboratoire. Comme le produit est testé en situation d’utilisation réelle, on peut faire une analyse de l’utilisation des technologies dans les situations naturelles (au travail, à la maison, etc.).

Source image : https://www.ergolab.net/articles/test-utilisateur-ergonomie-2.php

Source image : https://www.ergolab.net/articles/test-utilisateur-ergonomie-2.php

Présentation des méthodes d’évaluation par verbalisation (Think Aloud), d’évaluation coopérative et d’évaluation a priori/a posteriori

La méthode d’évaluation par verbalisation (Think aloud) est une méthode très simple avec une grande puissance d’évaluation. Le concepteur se place derrière l’utilisateur et l’encourage à penser à haute voix lors de l’utilisation du système. Le concepteur prend note des verbalisations sans intervenir lors du test. Il faut gagner la confiance de l’utilisateur en lui expliquant que l’étude porte sur le système et non sur lui. Chaque condition du test doit être expliquée et justifiée, car le concepteur ne fournit aucune aide pendant le test. Les questions de l’utilisateur sont relevées par le concepteur, mais il n’y répond pas. La seule intervention du concepteur est lorsque l’utilisateur est dans une impasse grave (problème à résoudre).

La seconde méthode est l’évaluation coopérative. Il s’agit d’une technique qui cherche à identifier les points à modifier pour rendre un prototype plus utilisable. Il y a quatre étapes à suivre pour la mise en application de cette méthode. Premièrement, il faut définir le panel (futurs utilisateurs ou profils types du système) et recruter des utilisateurs cibles. Deuxièmement, il faut choisir et préparer des activités à faire durant le test, déterminer la durée du test et préparer un descriptif de l’’activité. Troisièmement, il faut organiser la séance de test. Le test doit laisser agir les utilisateurs. Leurs réactions seront enregistrées par vidéo, audio, etc. Il est possible de les questionner à la fin du test pour comprendre leur attitude et réaction. Quatrièmement, il faut analyser les résultats et définir les points à modifier.

La troisième méthode d’évaluation est la méthode a priori ou a posteriori.

L’évaluation a priori se fait pendant la conception mais juste avant l’utilisation. Elle vise à prévoir/identifier les besoins, les scénarios d’utilisation et les difficultés potentielles ou réelles des utilisateurs.

À l’inverse, l’évaluation a posteriori se fait pendant l’utilisation et après la conception. Elle vise à caractériser les points forts et les points faibles du système. Si cette évaluation se fait avant la diffusion du système, elle comporte des tests d’acceptabilité, de vérification des performances et d’intégration dans l’action. Si l’évaluation se fait pendant la diffusion du système, plusieurs éléments seront pris en compte comme la satisfaction, les incidents, le soutien de l’utilisateur, la maintenance, les améliorations ou, encore, l’image du produit auprès du grand public. Avant d’acheter, les utilisateurs vont comparer les logiciels selon la technique par rapport à l’utilisabilité.

Étude de cas

Les méthodes d’évaluation permettent d’assurer la qualité de conception d’une IHM, d’établir un diagnostic d’usage des systèmes existants, de contrôler a priori ou a posteriori la qualité ergonomique du système, de comparer ses avantages et inconvénients et de faire une évaluation comparative de différents systèmes dans l’objectif d’un choix en fonction de l’utilisabilité.

En premier lieu, il faut définir le système et les fonctionnalités du système à évaluer. Prenons par exemple le site Kijiji.ca. La tâche sera d’analyser la méthode de recherche pour acheter une chaise de bureau. Par exemple, plusieurs chemins existent pour trouver les sièges de bureau en cuir noir pour un prix inférieur à 40 $.

Au moyen de ce scénario, il faut analyser l’utilité (la capacité fonctionnelle, la performance et l’assistance) et l’utilisabilité (facilité d’apprentissage, de mémorisation et d’utilisation, établissement du taux d’erreurs et de la satisfaction).

Le lieu est sur le terrain (chez les participants) et le panel des utilisateurs cibles sera des personnes ayant entre 30 et 45 ans. Le nombre d’utilisateurs soumis au test est de 12 utilisateurs.

Lors de la passation des tests, le concepteur se place près de l’utilisateur afin de prendre note de ses observations. L’utilisateur peut être filmé de manière que le concepteur puisse étoffer ses observations a posteriori.

Le concepteur peut relever des données quantitatives selon le nombre de clics, le nombre d’erreurs, le temps pour réaliser le scénario, etc.

Pour avoir des données qualitatives, on propose un questionnaire ainsi qu’un entretien pour approfondir certaines stratégies utilisées par l’utilisateur. (Exemples : Pourquoi avez-vous utilisé la barre de recherche en premier? Comment avez-vous trié les éléments de la liste? Est-ce que la publicité vous a gêné? etc.)

Exemples de questions sur ce site (en anglais) https://oldwww.acm.org/perlman/question.cgi?form=CSUQ

À la fin, le concepteur analyse les données recueillies et identifie les erreurs d’utilisation et les pistes d’amélioration possibles.

Bibliographie :

- https://deptinfo.cnam.fr/Enseignement/CycleSpecialisation/IHM/annee1011/conceptionEtEvaluation.pdf

- https://snakeeyes57.free.fr/fac/Master/M1/Interface%20Homme-Machine/Cours3-EvaluationSI.pdf